6月7日-8日,2025全球人工智能技术大会(GAITC 2025)在杭州举办。中科曙光携全栈AI基础设施多项核心成果深度参与本次大会,并携手中国人工智能学会成功举办“大模型时代的AI基础设施”专题活动,全方位展示在智能计算、智能存储、智能服务领域的技术创新与应用实践。

中科曙光高级副总裁李斌在致辞中表示,国产算力要实现突围发展,从单点技术突破向体系化、生态化创新升级是必然趋势。中科曙光在长期产业实践中反复打磨形成全栈AI基础设施软硬件产品矩阵,围绕算力的生产、聚集、释放、调度与服务环节,加速各行各业智能跃迁。

重构AI计算基础设施,打造坚实算力底座

AI大模型的爆发触发全球算力需求的指数级增长,国产AI算力行业迎来发展机遇,同时也面临能效、成本、生态、技术封锁等诸多挑战。响应时代之需,打造贯穿AI算力全链条的软硬协同基础设施是当前发展的关键之举。

中科曙光总裁助理、智能计算产品事业部总经理杜夏威指出,大模型创新正在加快改变AI算力结构,国产GPU加速卡迎来重大机遇,实现芯片-算法-模型深度耦合,已成为AI基础设施的重要创新方向。为此需要聚焦三大能力建设:一是建设面向业务场景的全栈软件,自底向上逐层完善软件栈覆盖,降低国产芯片与用户业务整合的门槛;二是围绕模型性能特性建立正向优化机制,结合芯片架构深入分析与测试,形成算法、算子、库、运行时的“贯穿式”优化链条;三是推进大模型行业赋能,协助客户解决大模型集成“最后一公里”问题,促进国产算力高效应用。

今年2月,中科曙光围绕国产GPU加速卡推出DeepAI深算智能引擎,集成GPU开发工具套件、人工智能基础软件系统DAS、人工智能应用平台DAP,让国产AI算力更适用、更好用,以软硬协同优化赋能从十亿级模型端侧推理到千亿级模型云端训练的全场景需求,同时也在大力推动产、学、研、用多方协作,共建创新引领、自主可控、开放包容的智算生态体系。

速度革新与容量革命,加速AI存储新范式

大模型训练推理过程不仅是AI计算密集型应用,也是数据密集型、IO敏感型应用。随着数据的流动,围绕数据采集、数据准备、模型训练、模型推理和数据归档,对存储能力的要求更高,如高带宽、低延时、高密度、低成本等。大模型不断创新及其在智能驾驶、具身智能、AI4S、智算中心等领域的应用,对先进存力的需求持续增加。

曙光存储副总裁张新凤认为,大模型时代的AI存储架构正在重塑,曙光存储团队基于二十年的技术积累与行业经验,正全力推动这一变革,过去一年里基于“AI加速”需求,持续迭代产品技术打造“超级隧道”,不仅满足关键客户与新兴场景对先进存力的极致需求,同时也引领了中国存储行业的发展,助推AI基础设施升级。

曙光存储首次提出的“超级隧道HyperTunnel”也在此次大会亮相,通过极简交互、零锁竞争和软硬融合的核心理念,构建起高效、低时延的数据传输路径。在曙光存储的两大产品——分布式全闪存储ParaStor、集中式全闪存储FlashNexus中,“超级隧道”都有不同维度的技术实现。在AI训练场景中,ParaStor系列可提供190GB/s带宽及500万IOPS,可将GPT - 4级别模型的训练周期从3个月压缩至1周,极致释放AI潜能;FlashNexus通过亿级IOPS、微秒级延迟的全球顶尖性能,极速支持AI推理决策。

可信云+AI,护航大模型全程全周期应用

随着数智化进程的加速,与云、大模型、数据相关的安全风险与挑战也与日俱增。传统的云上加密方案一般都是在云外部署独立的密码设备及服务,不仅增加了额外的设备成本与网络时延,而且无法满足大模型训练推理过程中,对硬件层、数据层、应用层的全方位、更高级的加密防护需求。

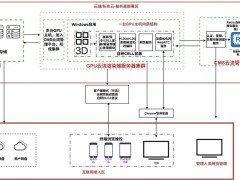

曙光云计算集团首席架构师王琪在演讲中提到,基于“全栈可信,云中生智”的发展战略,曙光云提出了“芯云融合”的解决方案,以国产x86芯片内置的安全处理器为云安全体系的可信根,实现硬件、云平台、数据、应用的安全可信闭环,为大模型全程应用提供全方位加密安全服务。

面向安全敏感的政企客户,曙光云从可信根出发,形成完整的全栈可信云方案,涵盖安全云服务器、可信安全容器、机密计算服务器、融合密码服务、大模型安全沙箱等,同时与一线安全厂商合作,基于大模型构建了智能安全运营服务体系,从平台安全、计算安全、数据安全、传输安全、存储安全到审计安全,全方位为AI大模型的全生命周期保驾护航。

站在AI重塑世界的奇点时刻,唯有将产品与行业需求深度耦合,才能让技术的价值落地生根,成为驱动产业跃迁的关键动能。中科曙光将持续完善全栈AI基础设施,助力中国AI产业突破算力瓶颈、生态壁垒与应用鸿沟,以数据为船,以算力为桨,以模型为帆,共同驶向智能时代的璀璨未来。